Intel hat ein KI-Modell vorgestellt, das 360-Grad-Bilder aus Text generiert. Das Modell heißt Latent Diffusion Model for 3D (LDM3D) und wurde in Zusammenarbeit mit Blockade Labs entwickelt. Blockade Labs ist eine Plattform, die es Kreativen ermöglicht, ihre Visionen in virtuelle Realität umzusetzen.

Sie haben es eilig? Dann speichern Sie diesen Blogartikel von R23 als PDF

Brauchen Sie den Inhalt dieses Artikels “360-Grad-Bilder aus Text generieren. Latent Diffusion Model for 3D (LDM3D)” schnell und bequem? Dann speichern Sie ihn doch einfach als PDF!

LDM3D nutzt KI, um realistische visuelle 3D-Inhalte zu erstellen, die eine Tiefenkarte enthalten, um 360-Grad-Ansichten zu ermöglichen. Intel behauptet, dass es das branchenweit erste Modell dieser Art sei. Das Modell soll Inhalte, Metaverse-Anwendungen und digitale Erlebnisse revolutionieren und eine Vielzahl von Branchen verändern.

LDM3D kann aus Textbeschreibungen detaillierte 360-Grad-Panoramen erzeugen, zum Beispiel von einem ruhigen tropischen Strand, einem modernen Wolkenkratzer oder einem Science-Fiction-Universum. Das ermöglicht innovative Anwendungen für Branchen wie Unterhaltung, Spiele, Innenarchitektur, Immobilienangebote, virtuelle Museen und immersives Virtual-Reality-Erlebnis (VR).

Seiteninhalt

Was sind die Anwendungsbereiche von LDM3D?

Die Anwendungsbereiche von LDM3D sind vielfältig und spannend. LDM3D kann aus Textbeschreibungen detaillierte 360-Grad-Panoramen erzeugen, die für verschiedene Branchen und Zwecke genutzt werden können. Zum Beispiel:

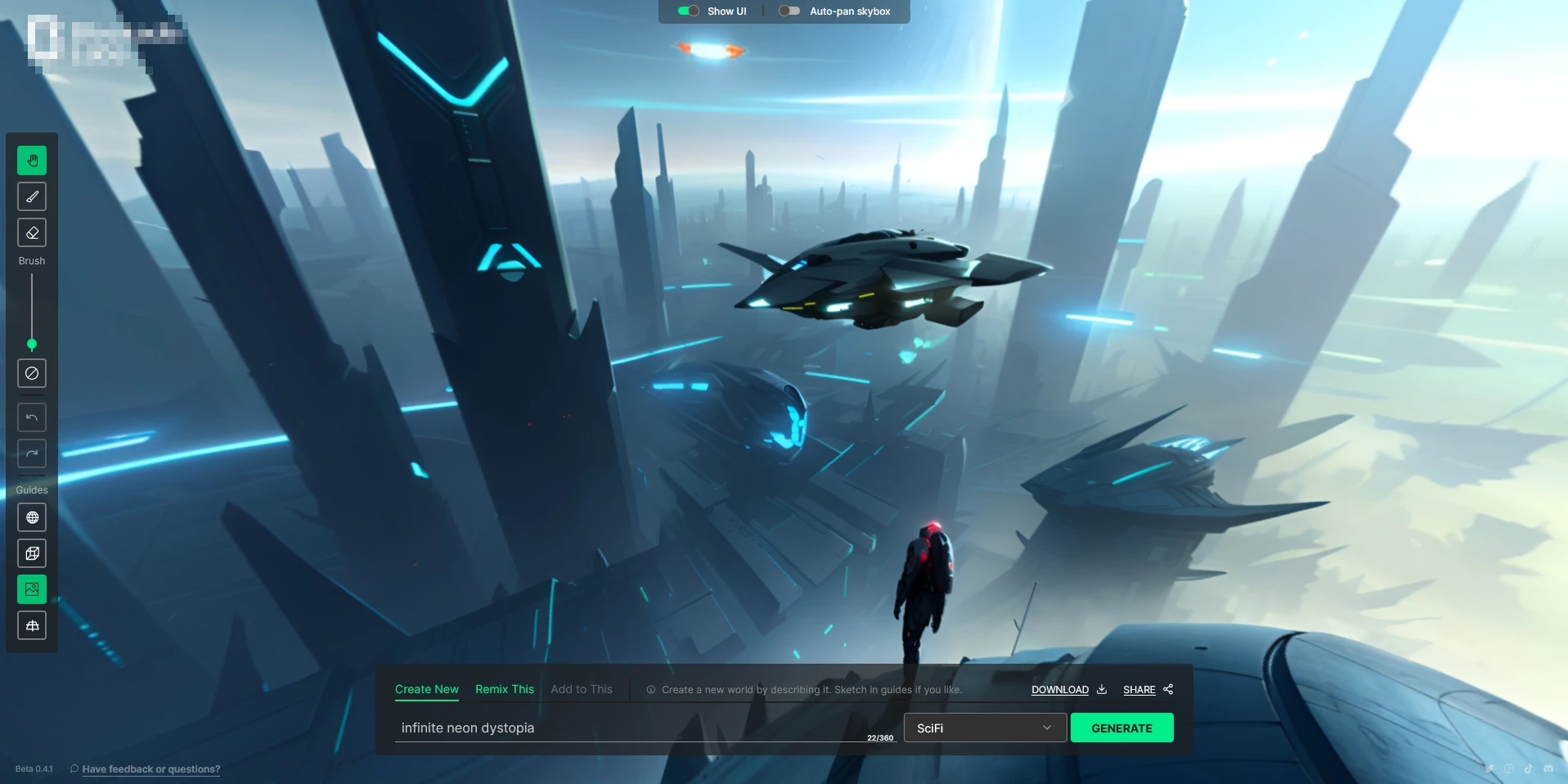

- Unterhaltung und Spiele: LDM3D kann immersive und realistische virtuelle Welten erschaffen, die die Spieler:innen in verschiedene Szenarien eintauchen lassen. Zum Beispiel könnte man ein Science-Fiction-Universum, eine historische Stadt oder eine Fantasy-Landschaft aus Text generieren und erkunden.

- Innenarchitektur und Immobilienangebote: LDM3D kann potenziellen Käufer:innen oder Mieter:innen eine virtuelle Tour durch eine Immobilie ermöglichen, die ihren Wünschen und Vorstellungen entspricht. Zum Beispiel könnte man ein modernes Wohnzimmer, eine gemütliche Küche oder ein luxuriöses Schlafzimmer aus Text beschreiben und visualisieren.

- Virtuelle Museen und Bildung: LDM3D kann kulturelle und historische Sehenswürdigkeiten, Kunstwerke und Ausstellungen aus Text rekonstruieren und zugänglich machen. Zum Beispiel könnte man das Kolosseum in Rom, die Mona Lisa im Louvre oder die Pyramiden in Ägypten aus Text darstellen und besuchen.

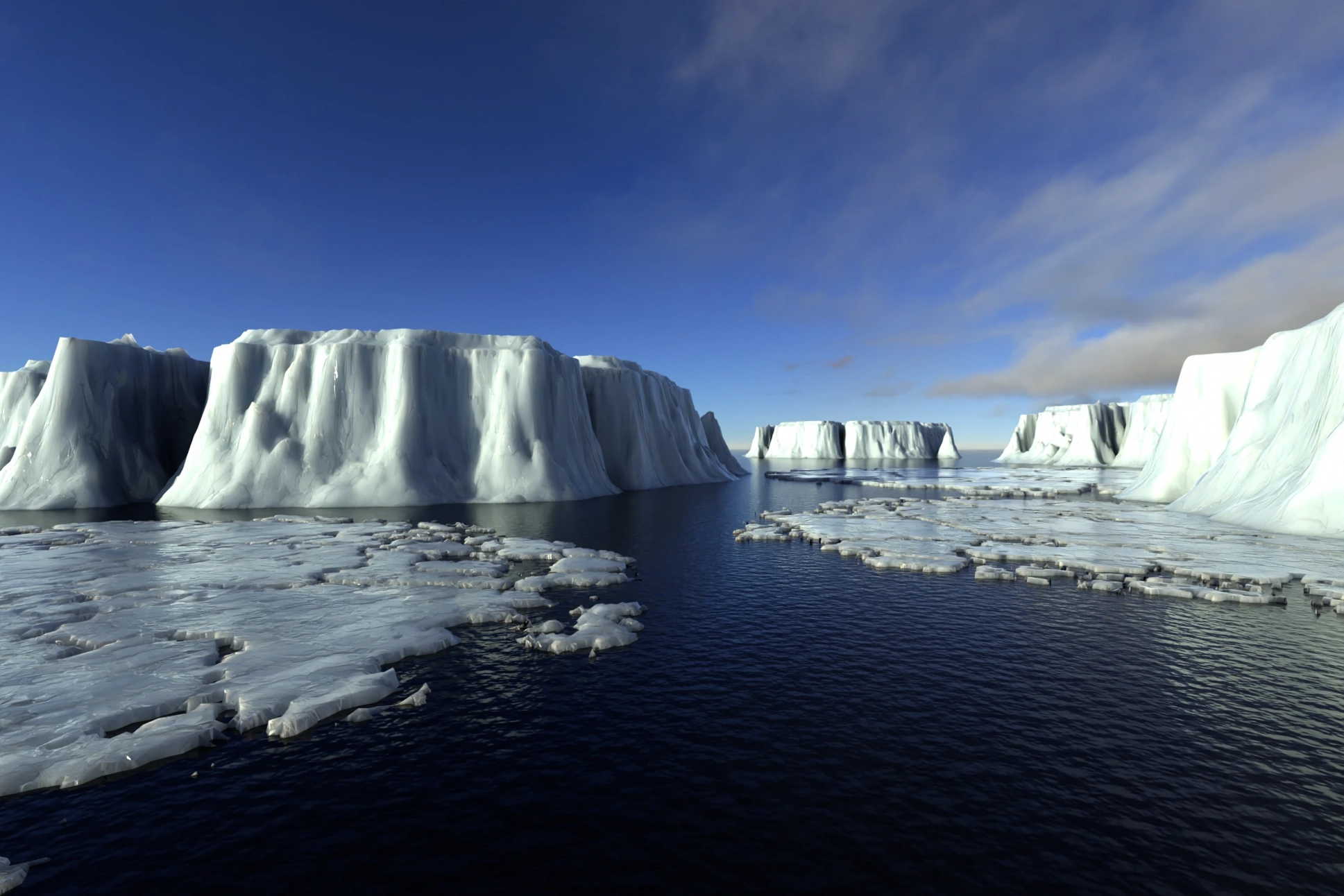

- Immersives Virtual-Reality-Erlebnis (VR): LDM3D kann personalisierte und interaktive VR-Erlebnisse schaffen, die die Nutzer:innen in verschiedene Umgebungen und Situationen versetzen. Zum Beispiel könnte man einen ruhigen tropischen Strand, einen atemberaubenden Sonnenuntergang oder einen spannenden Fallschirmsprung aus Text erleben.

Wie kann ich LDM3D verwenden?

Um LDM3D zu verwenden, benötigen Sie eine geeignete Software, die das Modell unterstützt. Eine Möglichkeit ist, die Hugging Face-Plattform zu nutzen, die eine Reihe von KI-Modellen und -Pipelines anbietet, darunter LDM3D. Hugging Face ermöglicht es Ihnen, LDM3D mit Python-Code zu verwenden, um 360-Grad-Bilder aus Text zu generieren. Zum Beispiel können Sie den folgenden Code ausführen, um ein Bild von einigen Zitronen auf einem Tisch zu erzeugen:

from diffusers import StableDiffusionLDM3DPipeline

pipe_ldm3d = StableDiffusionLDM3DPipeline.from_pretrained("Intel/ldm3d")

prompt = "A picture of some lemons on a table"

output = pipe_ldm3d(prompt)

rgb_image, depth_image = output.rgb, output.depth

rgb_image[0].save("lemons_ldm3d_rgb.jpg")

depth_image[0].save("lemons_ldm3d_depth.png")Sie können auch andere Textbeschreibungen verwenden, um verschiedene 360-Grad-Bilder zu erzeugen. Sie können die Ergebnisse in Ihrem lokalen Ordner speichern oder online anzeigen.

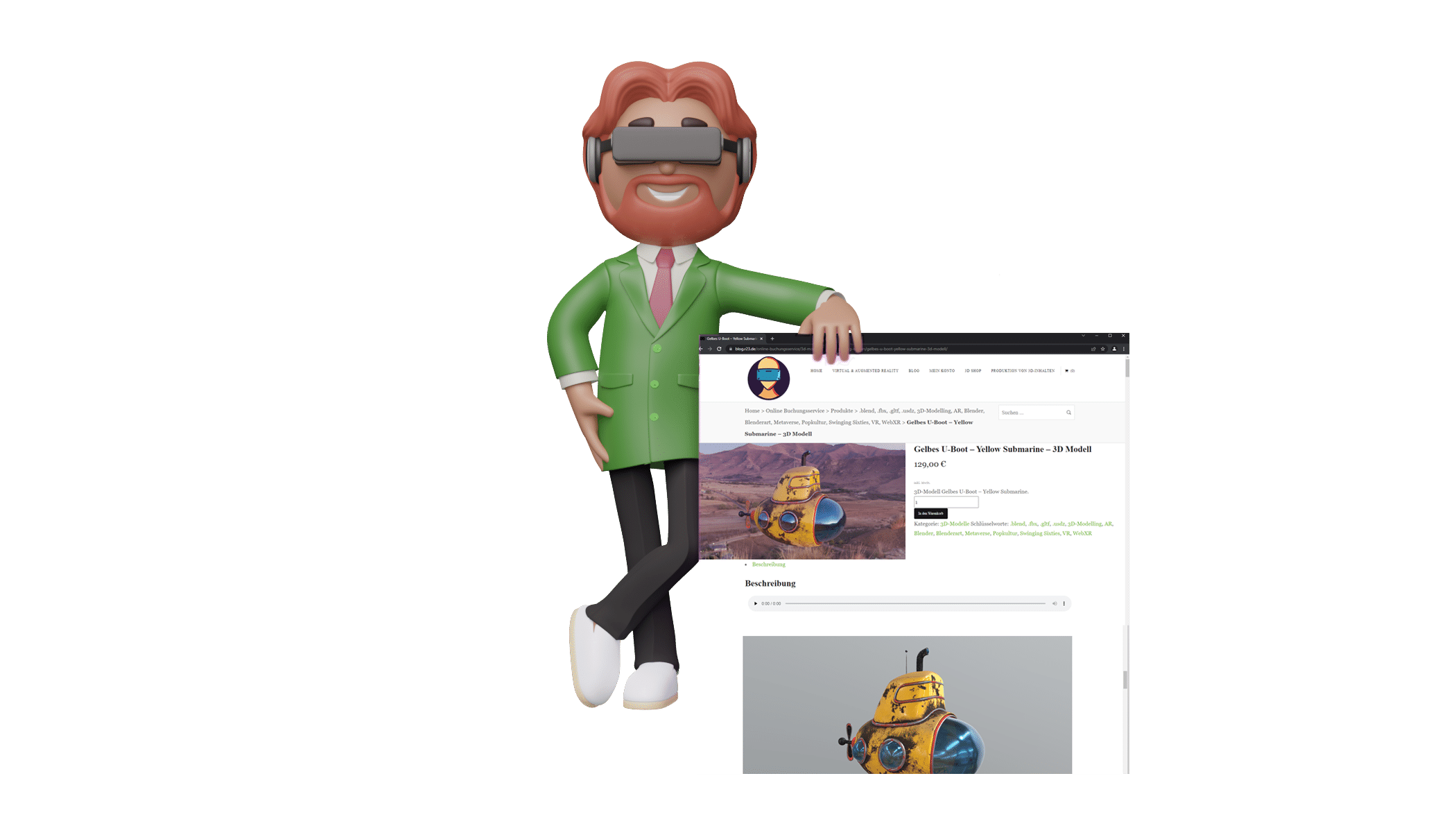

Eine andere Möglichkeit ist, die Blockade Labs-Plattform zu verwenden, die eine intuitive Benutzeroberfläche bietet, um LDM3D zu verwenden¹. Blockade Labs ermöglicht es Ihnen, Ihre eigenen virtuellen Welten aus Text zu erstellen und zu teilen. Sie können auch die Werke anderer Kreativer erkunden und inspirieren lassen. Blockade Labs ist noch in der Beta-Phase, aber Sie können sich für einen frühen Zugang anmelden.

Wie kann ich Hugging Face verwenden?

Um Hugging Face zu verwenden, müssen Sie zunächst ein Konto erstellen und sich anmelden. Sie können dies auf der Hugging Face-Website tun. Dort finden Sie auch eine umfangreiche Dokumentation, die Ihnen zeigt, wie Sie die verschiedenen Funktionen und Dienste von Hugging Face nutzen können.

Einige der wichtigsten Funktionen von Hugging Face sind:

- Repositories: Sie können Ihre eigenen KI-Modelle, Datensätze und Räume auf Hugging Face hochladen, verwalten und teilen. Sie können auch die Werke anderer Nutzer:innen durchsuchen, herunterladen und verwenden.

- Inference API: Sie können mehr als 50.000 Modelle über die öffentliche Inference API von Hugging Face verwenden, die Skalierbarkeit eingebaut hat. Sie können auch Ihre eigenen Modelle über die Inference API bereitstellen und abrufen.

- Accelerate: Sie können Ihre KI-Trainings- und Inferenz-Pipelines mit Accelerate beschleunigen, einem Python-Paket, das die Verwendung von GPUs, TPUs und mehreren Maschinen vereinfacht.

Was sind die Vorteile von LDM3D gegenüber anderen Modellen?

LDM3D hat einige Vorteile gegenüber anderen Modellen, die 360-Grad-Bilder aus Text generieren können. Einige davon sind:

- LDM3D erzeugt eine Tiefenkarte, die eine 360-Grad-Ansicht ermöglicht. Andere Modelle, wie zum Beispiel DALL-E, erzeugen nur 2D-Bilder, die keine räumliche Tiefe oder Perspektive haben. LDM3D hingegen erzeugt eine Tiefenkarte, die angibt, wie weit jedes Pixel vom Betrachter entfernt ist. Das ermöglicht es, das Bild aus verschiedenen Blickwinkeln zu betrachten und zu drehen.

- LDM3D nutzt eine latente stabile Diffusion, um realistische und konsistente Bilder zu erzeugen. Andere Modelle, wie zum Beispiel GPT-3, nutzen eine autoregressive Methode, um Bilder Pixel für Pixel zu erzeugen. Das kann zu Inkonsistenzen oder Artefakten im Bild führen. LDM3D hingegen nutzt eine latente stabile Diffusion, die ein Rauschen in ein Bild umwandelt. Das führt zu realistischeren und konsistenteren Bildern, die der Textbeschreibung entsprechen.

- LDM3D ist flexibel und anpassbar für verschiedene Anwendungen und Branchen. Andere Modelle, wie zum Beispiel CLIP, sind auf bestimmte Domänen oder Kategorien beschränkt. LDM3D hingegen kann aus jeder beliebigen Textbeschreibung ein 360-Grad-Bild erzeugen, das für verschiedene Anwendungen und Branchen geeignet ist. Zum Beispiel kann LDM3D Bilder von Landschaften, Gebäuden, Kunstwerken oder Science-Fiction-Szenarien erzeugen.

Kann ich auch Videos oder Animationen mit LDM3D erstellen?

LDM3D ist ein Modell, das 360-Grad-Bilder aus Text generiert, aber es kann keine Videos oder Animationen erstellen. Um Videos oder Animationen aus Text zu erstellen, benötigen Sie eine andere Software, die diese Funktion unterstützt. Es gibt einige Optionen auf dem Markt, die Sie ausprobieren können. Zum Beispiel:

- Adobe Animate: Adobe Animate ist eine Software, die Ihnen erlaubt, interaktive Animationen für verschiedene Plattformen zu erstellen. Sie können vektorbasierte Animationen für Spiele, Web und Film erstellen und mit 3D-Funktionen experimentieren. Sie können Adobe Animate kostenlos testen oder ein Abo abschließen.

- Animaker: Animaker ist eine Online-Plattform, die Ihnen erlaubt, animierte Videos in der Cloud zu erstellen. Sie können aus Tausenden von Vorlagen, Charakteren, Hintergründen und Musik wählen und Ihre eigenen Videos mit Drag & Drop erstellen. Sie können Animaker kostenlos nutzen oder ein Upgrade auf einen Premium-Plan durchführen.

- Visme: Visme ist ein Online-Design-Tool, das Ihnen erlaubt, animierte Bilder, Infografiken, Präsentationen und andere visuelle Elemente zu erstellen. Sie können aus Tausenden von animierten Vorlagen wählen und Ihre eigenen Animationen mit einer Zeitleiste anpassen. Sie können Visme kostenlos nutzen oder einen kostenpflichtigen Plan wählen.

Kann ich auch andere Arten von Bildern oder Modellen mit LDM3D generieren?

LDM3D ist ein Modell, das 360-Grad-Bilder aus Text generiert, aber es kann auch andere Arten von Bildern oder Modellen generieren. Einige davon sind:

- RGBD-Bilder: LDM3D kann nicht nur RGB-Bilder (Rot-Grün-Blau), sondern auch RGBD-Bilder (Rot-Grün-Blau-Tiefe) erzeugen. RGBD-Bilder enthalten eine Tiefenkarte, die angibt, wie weit jedes Pixel vom Betrachter entfernt ist. Das ermöglicht es, das Bild aus verschiedenen Blickwinkeln zu betrachten und zu drehen.

- 3D-Modelle: LDM3D kann auch 3D-Modelle aus Text generieren, die in verschiedenen Formaten exportiert werden können. Zum Beispiel kann man ein 3D-Modell im OBJ-Format erzeugen, das die Geometrie, die Textur und die Beleuchtung des Objekts enthält. Das ermöglicht es, das Objekt in verschiedenen Anwendungen zu verwenden, wie zum Beispiel Blender, Unity oder Sketchfab.

- Panorama-Bilder: LDM3D kann auch Panorama-Bilder aus Text generieren, die eine breite und umfassende Ansicht einer Szene bieten. Zum Beispiel kann man ein Panorama-Bild von einem Berggipfel, einer Stadtlandschaft oder einem Sonnenuntergang erzeugen. Das ermöglicht es, die Szene in einer hohen Auflösung und mit einem weiten Sichtfeld zu betrachten.

Wie kann ich RGBD-Bilder oder 3D-Modelle mit LDM3D generieren?

Um RGBD-Bilder oder 3D-Modelle mit LDM3D zu generieren, können Sie die Hugging Face-Plattform nutzen, die das Modell unterstützt¹. Sie können LDM3D mit Python-Code verwenden, um RGBD-Bilder oder 3D-Modelle aus Text zu generieren. Zum Beispiel können Sie den folgenden Code ausführen, um ein RGBD-Bild von einem Schloss in den Bergen zu erzeugen:

from diffusers import StableDiffusionLDM3DPipeline

pipe_ldm3d = StableDiffusionLDM3DPipeline.from_pretrained("Intel/ldm3d")

prompt = "A picture of a castle in the mountains"

output = pipe_ldm3d(prompt)

rgb_image, depth_image = output.rgb, output.depth

rgb_image[0].save("castle_ldm3d_rgb.jpg")

depth_image[0].save("castle_ldm3d_depth.png")Um ein 3D-Modell im OBJ-Format zu erzeugen, können Sie den folgenden Code ausführen:

from diffusers import StableDiffusionLDM3DPipeline

pipe_ldm3d = StableDiffusionLDM3DPipeline.from_pretrained("Intel/ldm3d")

prompt = "A picture of a castle in the mountains"

output = pipe_ldm3d(prompt)

obj_file = output.obj

obj_file[0].save("castle_ldm3d.obj")Sie können auch andere Textbeschreibungen verwenden, um verschiedene RGBD-Bilder oder 3D-Modelle zu erzeugen. Sie können die Ergebnisse in Ihrem lokalen Ordner speichern oder online anzeigen.

Wie kann ich die Qualität der generierten Bilder verbessern?

Um die Qualität der generierten Bilder zu verbessern, gibt es einige Schritte, die Sie ausführen können. Einige davon sind:

- Ändern Sie die Lichtverhältnisse in einem Foto mit den Tools Kontrast, Helligkeit und Schatten. Sie können die Belichtung, die Farben und die Stimmung eines Bildes anpassen, indem Sie diese Einstellungen in einem Bildbearbeitungsprogramm wie Adobe Photoshop oder PhotoDirector ändern.

- Bearbeiten Sie die Farben mit Sättigung und Wärme. Sie können die Intensität und den Farbton der Farben in einem Bild ändern, indem Sie diese Einstellungen in einem Bildbearbeitungsprogramm wie Adobe Photoshop oder PhotoDirector anpassen.

- Verbessern Sie die Bildqualität mit dem Schärfen-Tool, um Unschärfe zu reduzieren. Sie können die Details und die Klarheit eines Bildes erhöhen, indem Sie das Schärfen-Tool in einem Bildbearbeitungsprogramm wie Adobe Photoshop oder PhotoDirector verwenden.

- Verwenden Sie ein KI-gestütztes Tool zur Rauschunterdrückung, um Bildrauschen zu entfernen. Sie können das Rauschen in einem Bild reduzieren, indem Sie ein KI-gestütztes Tool wie PhotoDirector oder Hugging Face verwenden. Diese Tools nutzen künstliche Intelligenz, um das Rauschen zu erkennen und zu entfernen, ohne die Bildqualität zu beeinträchtigen.

- Verwenden Sie ein KI-gestütztes Tool zur KI Bildoptimierung, um die Bildqualität automatisch zu verbessern. Sie können die Bildqualität in wenigen Sekunden verbessern, indem Sie ein KI-gestütztes Tool wie PhotoDirector oder Hugging Face verwenden. Diese Tools nutzen künstliche Intelligenz, um die besten Einstellungen für Kontrast, Helligkeit, Farbe und Schärfe für jedes Bild auszuwählen.

Eine Schritt-für-Schritt-Anleitung, wie Sie auf huggingface.co den Code ausführen können.

Dieses Tutorial ist als praktischer Leitfaden gedacht und behandelt keine theoretischen Hintergründe.

Für die Richtigkeit der Inhalte dieses Tutorials gebe ich keinerlei Garantie. Der hier gezeigte Weg ist nicht der einzige, es ist lediglich, der, den ich bevorzuge.

Hier sind die Schritte, die Sie befolgen müssen:

Um das LDM3D-Modell auf Hugging Face zu verwenden, können Sie das Modell Intel/ldm3d verwenden. Dieses Modell ist eine Pipeline, die das LDM3D-Modell verwendet, um ein 3D-Modell im OBJ-Format aus einem Text zu erzeugen. Sie können dieses Modell in Ihrem Space verwenden, indem Sie die diffusers Bibliothek installieren und die StableDiffusionLDM3DPipeline Klasse importieren. Sie können dann Ihr Text-Prompt als Eingabe für die Pipeline verwenden und das generierte OBJ-Modell speichern.

Um einen neuen Space auf Hugging Face zu erstellen, müssen Sie die Spaces Hauptseite besuchen und auf Create new Space klicken. Sie müssen dann einen Namen für Ihren Space wählen und eine Beschreibung hinzufügen. Sie können auch ein Docker-Template auswählen, das Ihre Umgebung definiert und steuert. Sie können sich einige Beispiele für Docker Spaces auf der Hugging Face Dokumentation ansehen. Ein mögliches Template ist das FastAPI app serving a static site and using transformers Template, das FastAPI als Server verwendet und transformers importiert. Sie müssen nur die diffusers Bibliothek hinzufügen und die entsprechende Pipeline initialisieren. Sie können auch Ihr eigenes Dockerfile erstellen, wenn Sie mehr Kontrolle über die Umgebung haben möchten.

Nachdem Sie Ihren Space erstellt haben, können Sie Ihren Code hochladen und ausführen. Sie können auch andere Benutzer einladen, Ihren Space zu besuchen und Ihre ML-Demo auszuprobieren.

- Erstellen Sie ein Konto auf huggingface.co und melden Sie sich an. Sie können dies auf der Hugging Face-Website tun. Dort finden Sie auch eine umfangreiche Dokumentation, die Ihnen zeigt, wie Sie die verschiedenen Funktionen und Dienste von Hugging Face nutzen können.

- Installieren Sie die huggingface_hub CLI und führen Sie den Login-Befehl aus. Um Ihren Code auf das Hub hochladen zu können, müssen Sie sich authentifizieren. Der einfachste Weg, dies zu tun, ist, die huggingface_hub CLI zu installieren und den Login-Befehl auszuführen²:

pip install huggingface_hub

huggingface-cli login

Um den Token beim Login in die PowerShell zu kopieren, können Sie folgende Schritte ausführen:

- Öffnen Sie die PowerShell als Administrator. Sie können dies tun, indem Sie die Windows-Taste drücken, “PowerShell” eingeben und mit der rechten Maustaste auf “Windows PowerShell” klicken. Wählen Sie dann “Als Administrator ausführen” aus.

- Führen Sie den Login-Befehl der huggingface_hub CLI aus. Um sich bei Hugging Face zu authentifizieren, müssen Sie die huggingface_hub CLI installiert haben und den Login-Befehl ausführen. Geben Sie dazu den folgenden Befehl in die PowerShell ein:

huggingface-cli login- Kopieren Sie den Token aus dem Browser. Nachdem Sie den Login-Befehl ausgeführt haben, wird sich Ihr Standardbrowser öffnen und Sie zu einer Seite weiterleiten, auf der Sie Ihren Token sehen können. Kopieren Sie diesen Token, indem Sie ihn markieren und Strg+C drücken oder mit der rechten Maustaste auf “Kopieren” klicken.

- Fügen Sie den Token in die PowerShell ein. Gehen Sie zurück zur PowerShell und fügen Sie den Token ein, indem Sie Strg+V drücken oder mit der rechten Maustaste auf “Einfügen” klicken. Drücken Sie dann die Eingabetaste, um den Login abzuschließen.

- Erstellen Sie ein Repository auf dem Hub oder klonen Sie ein bestehendes. Um Ihren Code auf dem Hub zu speichern, müssen Sie ein Repository erstellen oder ein bestehendes klonen. Sie können dies über die Hugging Face-Website oder die huggingface_hub CLI tun:

# To create a new repository

huggingface-cli repo create your-repo-name

# To clone an existing repository

git clone https://huggingface.co/your-username/your-repo-name- Schreiben Sie Ihren Python-Code, um LDM3D zu verwenden, und speichern Sie ihn in einer Datei. Um LDM3D mit Python-Code zu verwenden, müssen Sie das Modell importieren und eine Textbeschreibung eingeben. Zum Beispiel können Sie den folgenden Code schreiben und ihn in einer Datei namens

ldm3d.pyspeichern:

from diffusers import StableDiffusionLDM3DPipeline

pipe_ldm3d = StableDiffusionLDM3DPipeline.from_pretrained("Intel/ldm3d")

prompt = "A picture of a castle in the mountains"

output = pipe_ldm3d(prompt)

rgb_image, depth_image = output.rgb, output.depth

rgb_image[0].save("castle_ldm3d_rgb.jpg")

depth_image[0].save("castle_ldm3d_depth.png")

- Das git-Repository noch initialisiert. Sie müssen das mit dem git init-Befehl tun, bevor Sie andere git-Befehle ausführen können. Sie können das mit dem folgenden Befehl tun:

git init- Führen Sie Ihren Python-Code aus und überprüfen Sie die Ergebnisse. Um Ihren Python-Code auszuführen, müssen Sie ihn in einem Terminal oder einer IDE Ihrer Wahl ausführen. Zum Beispiel können Sie den folgenden Befehl verwenden:

python ldm3d.pySie sollten dann ein RGB-Bild und ein Tiefenbild von einem Schloss in den Bergen erhalten, die in Ihrem lokalen Ordner gespeichert sind.

Wie funktioniert das LDM3D-Modell?

Das LDM3D-Modell ist ein neuartiges Diffusionsmodell, das generative KI verwendet, um realistische 3D-Visuelle Inhalte zu erzeugen. Es wurde von Intel in Zusammenarbeit mit Blockade Labs vorgestellt. Es ist das branchenweit erste Modell, das eine Tiefenkarte mit dem Diffusionsprozess erzeugt, um 3D-Bilder mit 360-Grad-Ansichten zu erstellen, die lebendig und immersiv sind.

Das LDM3D-Modell besteht aus zwei Komponenten: einem Autoencoder, der eine niedrigdimensionale, wahrnehmungsgleiche Datenrepräsentation erzeugt, und einem Diffusionsmodell, das diese Repräsentation verwendet, um sowohl ein RGB-Bild als auch eine Tiefenkarte aus einem Text-Prompt zu generieren. Das LDM3D-Modell wurde auf einem Datensatz feinabgestimmt, der aus einem Teilmenge des LAION-400M-Datensatzes besteht, einem groß angelegten Bild-Beschriftungs-Datensatz, der über 400 Millionen Bild-Beschriftungs-Paare enthält.

Das LDM3D-Modell ist ein einzelnes Modell, das sowohl ein RGB-Bild als auch eine Tiefenkarte erzeugt, was zu Einsparungen bei Speicherbedarf und Latenzverbesserungen führt. Die Einführung von LDM3D und DepthFusion ebnet den Weg für weitere Fortschritte in der generativen KI und Computer Vision für mehrere Ansichten. Diese Technologie hat das Potenzial, eine Vielzahl von Branchen zu transformieren, von Unterhaltung und Gaming bis hin zu Architektur und Design.

Wie kann ich das LDM3D-Modell verwenden?

Um das LDM3D-Modell zu verwenden, gibt es verschiedene Möglichkeiten, je nachdem, was Sie erreichen möchten. Hier sind einige Optionen, die Sie ausprobieren können:

- Wenn Sie 3D-Modelle aus Text generieren möchten, können Sie das Modell Intel/ldm3d auf Hugging Face verwenden. Dieses Modell ist eine Pipeline, die das LDM3D-Modell verwendet, um ein 3D-Modell im OBJ-Format aus einem Text zu erzeugen. Sie können dieses Modell in Ihrem Space verwenden, indem Sie die diffusers Bibliothek installieren und die StableDiffusionLDM3DPipeline Klasse importieren. Sie können dann Ihr Text-Prompt als Eingabe für die Pipeline verwenden und das generierte OBJ-Modell speichern. Sie können sich diese Dokumentation ansehen, um mehr über das Modell zu erfahren.

- Wenn Sie RGB-Bilder und Tiefenkarten aus Text generieren möchten, können Sie das LDM3D-Modell direkt verwenden. Sie können das Modell von der arXiv-Webseite herunterladen oder von der Papers With Code Webseite. Sie müssen dann das Modell in Ihrer Umgebung laden und Ihr Text-Prompt als Eingabe für das Modell verwenden. Das Modell wird Ihnen dann ein RGB-Bild und eine Tiefenkarte als Ausgabe liefern. Sie können sich diese PDF-Datei ansehen, um einige Beispiele für generierte Bilder und Tiefenkarten zu sehen.

- Wenn Sie immersive und interaktive 360-Grad-Erlebnisse aus Text generieren möchten, können Sie die Anwendung DepthFusion verwenden. Diese Anwendung verwendet die generierten RGB-Bilder und Tiefenkarten, um 360-Grad-Ansichten mit TouchDesigner zu erstellen. Sie können diese Webseite besuchen, um mehr über DepthFusion zu erfahren. Sie können auch ein kurzes Video ansehen, das den Ansatz zusammenfasst.

Kann ich das LDM3D-Modell auf meinem Computer ausführen?

Dieses Tutorial ist als praktischer Leitfaden gedacht und behandelt keine theoretischen Hintergründe.Für die Richtigkeit der Inhalte dieses Tutorials gebe ich keinerlei Garantie. Der hier gezeigte Weg ist nicht der einzige, es ist lediglich, der, den ich bevorzuge.

Um das LDM3D-Modell auf Ihrem Computer auszuführen, müssen Sie einige Systemanforderungen erfüllen. Sie müssen zum Beispiel Python 3.8 oder höher installiert haben, sowie die diffusers Bibliothek und das transformers Paket. Sie müssen auch das LDM3D-Modell von der arXiv-Webseite herunterladen¹ oder von der Papers With Code Webseite². Sie müssen dann das Modell in Ihrer Umgebung laden und Ihr Text-Prompt als Eingabe für das Modell verwenden. Das Modell wird Ihnen dann ein RGB-Bild und eine Tiefenkarte als Ausgabe liefern.Sie können auch Docker verwenden, um das LDM3D-Modell auszuführen. Sie müssen dazu eine Docker-Datei schreiben, die Ihre Umgebung definiert und steuert. Sie können dies tun, indem Sie eine Datei namens “Dockerfile” in Ihrem Repository erstellen und den folgenden Code hinzufügen:

FROM python:3.8-slim

RUN pip install diffusers transformers

COPY ldm3d_model /ldm3d_model

Sie müssen dann den folgenden Befehl ausführen, um ein Docker-Image aus dieser Datei zu erstellen:

docker build -t ldm3d .

Sie können dann das Docker-Image in Ihrem Space verwenden, indem Sie den folgenden Befehl ausführen:

docker run -it ldm3d

Sie können dann Ihr Text-Prompt als Eingabe für das Modell verwenden und das generierte RGB-Bild und die Tiefenkarte speichern.

Links

LDM3D: Latent Diffusion Model for 3D – arXiv.org.

LDM3D: Latent Diffusion Model for 3D – Papers With Code.

Quickstart – Hugging Face.

Spaces – Hugging Face.

Intel stellt KI-Modell vor, das 360-Grad-Bilder aus Text generiert – t3n.

Das könnte Sie auch interessieren

Skybox AI ist eine Website, die es Ihnen ermöglicht, eine 360-Grad-Cyberpunk-Landschaft zu erstellen, indem Sie einen Text eingeben, der beschreibt, was Sie sehen möchten. Zum Beispiel könnten Sie schreiben: „Eine futuristische Stadt mit Neonlichtern, Wolkenkratzern und fliegenden Autos“. Dann würde Skybox AI eine passende Skybox generieren, die Sie herunterladen oder teilen können. Fundstück der Woche: Skybox AI 360-Grad

Willkommen zu unserem neuesten Video! In diesem Video präsentieren wir Ihnen eine atemberaubende 360 Grad Eislandschaft, die mit modernster VR-Technologie und 5D-Rendering erstellt wurde. Sie werden das Gefühl haben, mitten in der Landschaft zu stehen und die Schönheit der Natur hautnah zu erleben.Dieses Video richtet sich an alle, die sich für beeindruckende Landschaften und innovative Technologien begeistern. Egal, ob Sie ein VR-Enthusiast sind oder einfach nur neugierig auf die Möglichkeiten von 360 Grad-Rendering sind, dieses Video wird Sie begeistern. Erleben Sie die Zukunft: 360 Grad VR Video veröffentlicht!

Wir haben in den letzten Tagen eine kleine Ausstellung mit wenigen Bildern auf Spatial.io für Freunde unseres Hauses eingerichtet. Mit diesem Blogbeitrag möchten wir Sie in unsere Welt einladen. Einladung in unsere Ausstellung auf Spatial.io

Schreiben Sie einen Kommentar